Esplorando Governance e Assurance dell'AI: Il caso della certificazione del sistema di gestione AI ISO/IEC 42001

Questo white paper spiega come la tua organizzazione possa sviluppare, gestire e soddisfare costantemente i requisiti interni ed esterni per un'implementazione efficace dell'AI nei processi, prodotti e servizi.

L'intelligenza artificiale (AI) sta trasformando il mondo e creando nuove opportunità e sfide per le aziende e la società in generale. Con l'arrivo di soluzioni di intelligenza artificiale generativa come ChatGPT e Copilot, la sperimentazione e il primo utilizzo dell'AI nelle organizzazioni sono esplosi. Le implementazioni di successo dimostrano che l'AI può alimentare l'efficienza, la qualità, l'innovazione e la soddisfazione dei clienti. Tuttavia, ogni nuova tecnologia porta con sé anche dei rischi. Le potenziali sfide e incertezze legate all'AI devono essere gestite e mitigate per garantire uno sviluppo, un'applicazione e un uso sicuri, affidabili ed etici.

In questo scenario, il ruolo di un sistema di gestione dell'AI (AIMS) basato sullo standard ISO/IEC 42001 diventa essenziale per le organizzazioni che vogliono gestire ed intraprendere il loro percorso con l’intelligenza artificiale. Un approccio strutturato costringe a "pensare prima di agire" e a valutare continuamente performance e risultati. Lo standard di riferimento sulla gestione dell'AI, sull'approccio alla gestione del rischio e sulla certificazione di terza parte è già riconosciuto come un pilastro fondamentale per guidare lo sviluppo e fornire soluzioni di AI affidabili.

La necessità di un uso sicuro e responsabile dell'AI

L'esigenza di un'AI affidabile nasce dalle sempre più frequenti sperimentazioni e adozioni delle sue numerose applicazioni, dalla crescente consapevolezza e aspettative degli stakeholder e infine dall'evoluzione del panorama etico e normativo. Di conseguenza, le organizzazioni non possono sfruttare i vantaggi dell'AI se non viene colmato il divario di fiducia tra gli sviluppatori e gli utenti dell'AI. Il ‘ trust gap’ si riferisce alla potenziale mancanza di fiducia e trasparenza nei prodotti e/o servizi abilitati all'AI della tua organizzazione. Per fare un esempio, se agli utenti non è chiaro come i sistemi di AI prendano le decisioni, potrebbe portare a incertezza e scetticismo sulla sicurezza, sulle considerazioni etiche, sulla protezione della privacy dei dati e sulla credibilità generale. In poche parole, la nostra fiducia in una tecnologia dipende dalla capacità di comprenderne appieno l'utilizzo e di avere la certezza che questa sia sicura e affidabile.

Colmare questa lacuna di fiducia è fondamentale per promuovere e ampliare la diffusione di prodotti e servizi di intelligenza artificiale.

È necessario fornirne un'implementazione sicura, affidabile, responsabile ed etica. Inoltre, è fondamentale costruire la fiducia nell’AI sia agli stakeholder interni, come dipendenti e dirigenti, sia agli stakeholder esterni, come clienti e azionisti.

Per conseguire e comprovare l'affidabilità delle tue soluzioni, è indispensabile un metodo sistematico che abbracci tutto il ciclo di vita dell'AI. Questo include l'analisi degli stakeholder, l'istituzione di adeguate misure di protezione come le linee guida etiche, la definizione delle priorità nei casi d'uso, l'individuazione dei rischi e l'implementazione dei controlli necessari. Quando ci si concentra sul gap di fiducia, si possono identificare esigenze e aspettative chiare. Ad esempio, la tua organizzazione dovrebbe:

- identificare e dare priorità alle aree e alle applicazioni in cui l'AI può aggiungere valore e creare impatto.

- comprenderne i benefici e i rischi.

- stabilire e mantenere una cultura di fiducia, trasparenza e responsabilità all'interno delle organizzazioni.

- valutare e misurare le performance e la qualità dei sistemi di AI, assicurando che siano conformi ai principi di affidabilità, alla legislazione vigente o futura e ai requisiti dei clienti

- organizzare i ruoli e le responsabilità nelle organizzazioni, aspetto particolarmente critico in un campo tecnologico in continua evoluzione e sviluppo.

- adottare e implementare processi basati su standard di best practice (come ISO/IEC 42001) per lo sviluppo, l'implementazione e la governance dell'AI.

- comunicare l'affidabilità dei sistemi di AI agli stakeholder, fornendo prove di conformità alle best practice, alle leggi e alle normative.

Pur non essendo esaustiva, questa è una panoramica delle esigenze e delle aspettative principali. La norma ISO/IEC 42001 sul sistema di gestione dell'intelligenza artificiale è stata concepita per fornire una guida e una struttura che permettano di affrontare efficacemente questi aspetti.

Ruolo della standardizzazione nella gestione dell'AI

Ogni nuova tecnologia comporta dei rischi. Il panorama in continua evoluzione dell'AI, unito all'enorme potenziale della sua applicazione nei vari settori, alimenta ancora di più questo aspetto. Ed è impossibile, per citare un esempio, prevedere tutti i risultati nella fase di progettazione.

È in questo contesto che gli standard dei sistemi di gestione come la ISO/IEC 42001 diventano particolarmente importanti. Quando è necessario guadagnare la fiducia del pubblico, la standardizzazione e la certificazione sono elementi cruciali. Oltre a considerazioni di carattere legale, normativo ed etico, la standardizzazione diventa un mezzo per consentire la scalabilità, incorporare la sicurezza e guidare le organizzazioni in un territorio sconosciuto qual è attualmente l'AI.

Gli standard stabiliscono la terminologia essenziale, promuovono le norme del settore e raccolgono le best practice per la valutazione e il miglioramento. Inoltre, poiché promuovono trasparenza e responsabilità, contribuiranno anche all'accettazione sociale. Offrono una base per la conformità normativa e l'adozione da parte del settore e accelerano la capacità di sfruttare il potenziale globale dell'AI in modo sicuro, responsabile ed etico, con le necessarie trasparenza, fiducia e sicurezza tra utenti e stakeholder.

Ruolo dei sistemi di gestione dell'intelligenza artificiale

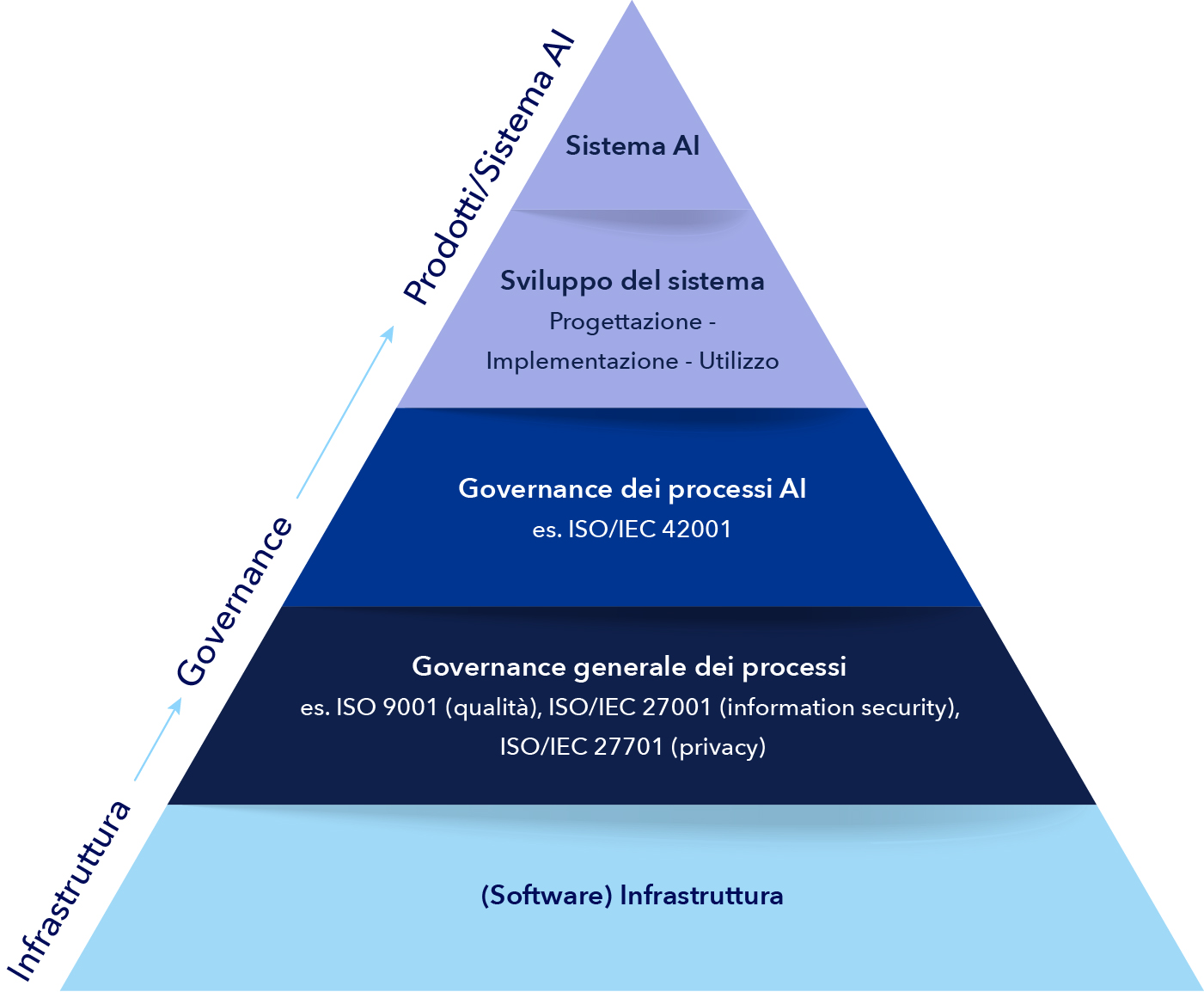

Gli standard e le certificazioni dei sistemi di gestione possono fungere da solide fondamenta per le organizzazioni che intendono organizzare la propria governance intorno all'AI (cfr. figura 1). Lo standard internazionale per i sistemi di gestione dell'AI ISO/IEC 42001 fornisce indicazioni e requisiti per le organizzazioni che sviluppano, distribuiscono o utilizzano sistemi di AI.

Questo attesissimo standard è stato pubblicato alla fine del 2023 ed è applicabile e destinato all'uso in tutti i settori e da parte di organizzazioni di qualsiasi tipo e dimensione che siano coinvolte nello sviluppo, nella fornitura o nell'utilizzo di prodotti e/o servizi che sfruttano sistemi di intelligenza artificiale. Essendo uno standard ISO, è compatibile e complementare ad altri standard classici dei sistemi di gestione ISO, come ISO 9001 (qualità) e ISO/IEC 27001 (information security). La norma ISO/IEC 42001 è in grado di trovare un equilibrio tra la promozione dell'innovazione dell'AI e l'implementazione di una governance efficace.

Ciò significa che è possibile attingere e basarsi su qualsiasi sistema di gestione esistente e sulla governance generale dei processi. Lo standard si impegna a fornire un approccio completo per governare il modo in cui l'AI diventa parte integrante di prodotti, servizi o persino applicazioni interne.

Nello schema che segue l’ ISO/IEC 42001 è identificata come lo strumento di governance dei processi nella "pyramid of assurance”. Alla base della piramide si trova l'infrastruttura organizzativa. Tutto ciò deve essere presente per il funzionamento dell'organizzazione. Per governare e migliorare le loro performance, molte organizzazioni scelgono di implementare sistemi di gestione della qualità (ISO 9001), dell’information security (ISO/IEC 27001) o a qualsiasi altro standard di sistema di gestione. La certificazione diventa quindi il mezzo per dimostrare la conformità ai vari stakeholder.

L’ISO/IEC 42001 segue una struttura simile a quella degli altri standard di sistema di gestione ISO, e questo che facilital'integrazione del tuo attuale sistema con i requisiti dell’AIMS. Questo approccio alla governance dei processi stabilisce il presupposto per creare, sviluppare e impiegare sistemi di intelligenza artificiale affidabili.

Gli obiettivi principali della norma ISO/IEC 42001 sono:

- fornire un quadro e una metodologia per stabilire, implementare, mantenere e migliorare un sistema di gestione dell'AI, che copra l'intero ciclo di vita dell'AI, adottando un approccio basato sul rischio.

- consentire la dimostrazione e la comunicazione dell'affidabilità dei sistemi e dei processi di AI di un'organizzazione.

- aiutare la conformità normativa e legale, che diventerà sempre più critica con l'aumento delle normative nazionali e internazionali, come l'European AI Act già in vigore dall’agosto 2024.

- facilitare l'interoperabilità e l'integrazione di sistemi e processi di AI.

- promuovere la collaborazione e il coordinamento tra gli stakeholder.

- sostenere l'innovazione e il miglioramento dei sistemi e dei processi di AI.

- incoraggiare l'adozione e la diffusione delle best practice e degli standard di gestione dell'AI.

Il rapporto tra la norma ISO/IEC 42001 e le leggi e i regolamenti sull'AI dovrebbe essere sinergico e reciprocamente vantaggioso. Sebbene la legge europea sull'AI sia marcatamente incentrata sul prodotto, l'adozione di un sistema di gestione dell'AI fornisce una base su cui costruire e fornire sistemi di AI affidabili, coerenti e prevedibili; i controlli della norma sono in linea con quanto richiesto dalla normativa.

In definitiva, un sistema di gestione ben implementato e conforme a tutti gli standard pertinenti permetterà l'integrità, la privacy e l'uso etico dei dati, pur restando sufficientemente flessibile da poter integrare i requisiti in continua evoluzione dei clienti, dei progressi tecnologici, delle istanze legali e normative e così via.

La strada da seguire?

Per iniziare il processo di adozione di un sistema di gestione certificato ISO/IEC 42001, puoi utilizzare l’articolo di DNV “La certificazione ISO/IEC 42001 in 8 step” e lo strumento di autovalutazione che lo accompagna. Il processo inizia con una revisione da parte del senior management per identificare le ragioni principali per l'adozione di un AIMS. Successivamente, le organizzazioni devono ottenere lo standard ISO/IEC 42001 e stabilire una direzione strategica che corrisponda agli obiettivi identificati.

Le fasi successive comprendono la pianificazione e l'allocazione delle risorse, la comprensione e la mappatura dei processi chiave e l'identificazione delle esigenze di formazione del personale. La preparazione, lo sviluppo e l'implementazione dei processi e delle procedure applicabili sono fasi tipiche, ed è importante organizzare audit interni e revisioni della gestione per verificare l'efficacia del sistema lungo il percorso. L'utilizzo dello strumento di autovalutazione di DNV aiuterà a identificare le lacune rispetto ai requisiti dello standard e consentirà un approccio mirato per soddisfare i requisiti ISO/IEC 42001.

Perché scegliere DNV?

In qualità di organismo di certificazione leader a livello mondiale, DNV è il partner scelto da 80.000 aziende in tutto il mondo per le loro esigenze di certificazione dei sistemi di gestione e di formazione. Disponiamo di competenze, conoscenze del settore e capacità uniche per quanto riguarda l'AI e altri sistemi di gestione. Scegliendo DNV, otterrai:

- Un partner globale nella information security e nella tutela della privacy: Abbiamo una solida esperienza nella certificazione e nella formazione in materia di information security e privacy, fondamentale per la gestione dell'AI.

- Risk Based Certification™: Adottiamo un approccio proattivo alla certificazione basato sul rischio, il che significa che possiamo aiutare le organizzazioni a identificare tempestivamente i potenziali rischi nei loro sistemi di AI affinché vengano affrontati prima che diventino un problema.

- Lumina™: È il nostro strumento di benchmarking che fornisce approfondimenti e analisi del sistema di gestione, dalle lacune più comuni e le relative correzioni, alla panoramica completa di tutti i siti aziendali e confronti con i tuoi pari.

- Gestione della formazione: Soluzioni digitali per aiutare la tua azienda a gestire e provvedere a uno sviluppo coerente della consapevolezza e delle competenze dei dipendenti in tutta l'organizzazione.

- Auditor competenti che adottano un approccio pragmatico, ascoltando le esigenze del cliente e preoccupandosi di valutare la conformità allo standard.

- Processi di gestione del cliente strutturati per offrire una superior customer experience.

DNV si impegna a fornire servizi di assurance dell'AI affidabili e a valore aggiunto. Basandoci sul nostro ruolo di terza parte indipendente e sul principio di non scendere a compromessi in termini di qualità e integrità, collaboriamo con i clienti per aiutarli ad esplorare con fiducia le complessità dell'AI e le sfide ad essa correlate, fornendo la governance necessaria per sistemi di AI che siano affidabili e sicuri.